A sabedoria da multidão conectada

Os avanços nas plataformas de computação móvel, juntamente com as inovações que permitem a IA na borda, levaram a uma explosão cambriana de aplicativos que detectam e percebem o mundo com uma precisão sem precedentes.

A sabedoria da multidão conectada

Os avanços nas plataformas de computação móvel, juntamente com as inovações que permitem a IA na borda, levaram a uma explosão cambriana de aplicativos que detectam e percebem o mundo com uma precisão sem precedentes. As pilhas de percepção automotiva são apenas um (mas provavelmente o mais proeminente) exemplo disso. As câmeras que ajudam a detectar, rastrear e reagir a objetos e situações ao redor de um veículo são um dos principais componentes da tecnologia que possibilitará a autonomia total. O sensoriamento visual, no entanto, sofre dos mesmos problemas que os olhos têm - eles podem sentir apenas o que veem e são afetados negativamente por condições climáticas adversas, iluminação ruim e uma variedade de outros fatores ambientais. Nessas circunstâncias, a quantidade de potência de computação disponível em um único dispositivo ou veículo deixa de ser relevante para o problema em questão. Em vez disso, precisamos diminuir o zoom e analisar o problema em escala, que é onde se encontram as possíveis soluções. Os veículos conectados que coletam automaticamente dados sobre o ambiente e o comportamento ao dirigir podem rapidamente se tornar um vasto pipeline de agregação de informações de crowdsourcing. Em conjunto com outras modalidades de detecção (Radar, Lidar), o uso de informações de mapeamento de crowdsourcing é agora visto como o terceiro pilar sobre o qual se apóia a realização da autonomia total. O que começou como uma missão para permitir a integração e o fornecimento mais rápidos de soluções de segurança habilitadas para ADAS para frotas, agora é um ecossistema vibrante de alguns dos maiores e mais inovadores provedores de serviços de telemática (TSP) que impulsionam soluções de segurança para motoristas por meio do RideView. Milhares de motoristas de veículos comerciais e gerentes de frota nos Estados Unidos e Canadá dependem de alertas em tempo real e percepções acionáveis para garantir que suas frotas estejam seguras o tempo todo. Um subproduto imensamente benéfico disso? Uma rede de milhares de câmeras conectadas que coletam uma grande quantidade de dados anônimos sobre sinais de trânsito, qualidade das estradas, padrões agregados de comportamento ao volante e muito mais.

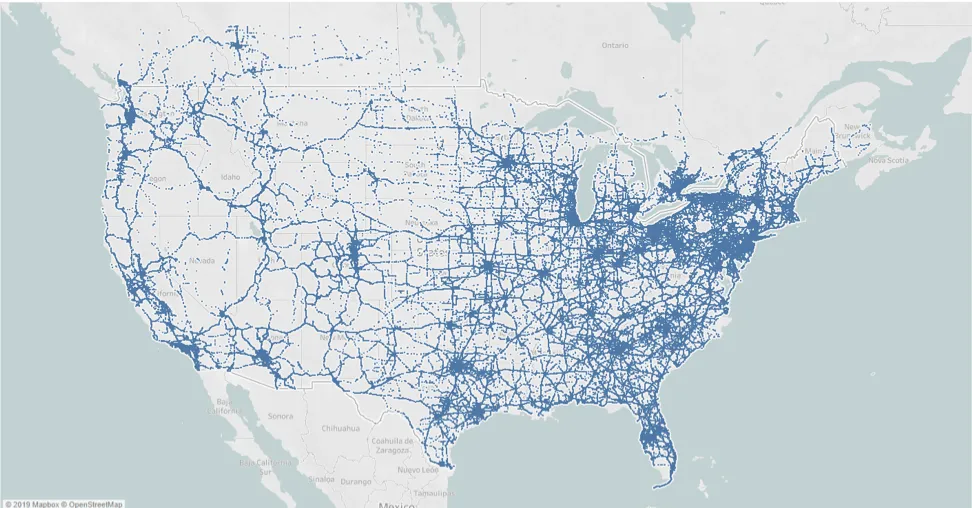

Crowdsourced Event Generator, um aprimoramento do nosso mecanismo de geração de eventos em tempo real baseado em ADAS. O primeiro caso de uso que ele potencializa é o mais simples e, ainda assim, em sua elegância, pressagia tudo o que é possível. O reconhecimento e a conformidade em tempo real do limite de velocidade e dos sinais de PARE tem sido uma proposta de valor central da nossa plataforma desde o início. Sabe-se que o excesso de velocidade é um dos principais indicadores de risco de acidentes, e nossos alertas ao motorista em tempo real ajudam a mitigar isso. Além disso, por não depender de bancos de dados de limites de velocidade existentes, que são atualizados com pouca frequência, isso garante que as frotas estejam sempre atualizadas sobre os limites que veem na operação diária. No entanto, conforme mencionado acima, há pontos cegos literais nessa dependência apenas da cognição visual. Em condições climáticas adversas (neblina, chuva, neve etc.), sob condições de iluminação ruins ou até mesmo quando obstáculos temporários ocultam um sinal - por exemplo, um caminhão classe 8 na faixa mais à direita - o sistema atinge seus limites. Graças aos milhares de veículos em nossa plataforma, agora temos uma cobertura significativa e orgânica de sinais de trânsito em toda a América do Norte, conforme mostrado na figura acima. Toda vez que um veículo em nossa plataforma detecta um novo limite de velocidade ou um sinal de PARE, ele é marcado com sua localização e adicionado a um corpus cada vez maior. Um algoritmo de filtragem e consenso no backend gera um banco de dados limpo, do qual apenas uma pequena fração é baixada e aplicada com base na localização atual. Livres das restrições do que um único sistema baseado em visão detecta, nossos algoritmos agora podem "ver" no escuro, na chuva e até mesmo quando os sinais estão completamente ocultos pelos veículos que passam. A resposta esmagadora dos primeiros usuários foi extremamente positiva, e esperamos ajudar nossos parceiros a levar isso aos usuários finais nos próximos meses. Dito isso, embora consideremos isso um marco importante, ainda é o Dia 1. Nas próximas semanas e meses, lançaremos aprimoramentos que aproveitam todos os dados valiosos que continuamos coletando em escala. Desde a detecção e a transmissão de sinais temporários de limite de velocidade que surgem em zonas de trabalho até o alerta antecipado de motoristas contra acidentes ou pontos críticos de direção imprudente, vamos nos concentrar em viabilizar casos de uso que ofereçam o maior valor para nossos parceiros e usuários finais.