La sabiduría de la multitud conectada

Los avances en las plataformas informáticas móviles, unidos a las innovaciones que permiten la IA en los bordes, han dado lugar a una explosión cámbrica de aplicaciones que perciben el mundo con una precisión sin precedentes.

La sabiduría de la multitud conectada

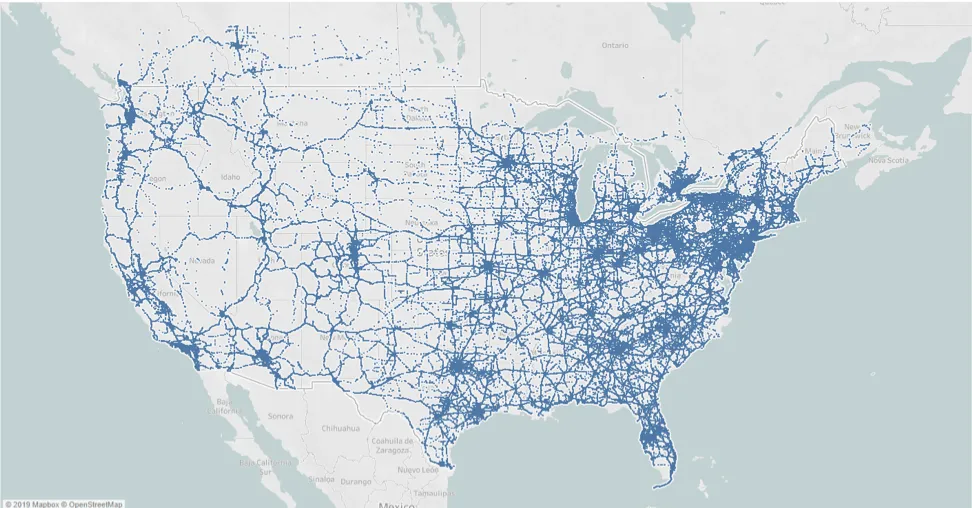

Los avances en las plataformas informáticas móviles, junto con las innovaciones que permiten la IA en los bordes, han dado lugar a una explosión cámbrica de aplicaciones que perciben el mundo con una precisión sin precedentes. Las pilas de percepción para automóviles son sólo un ejemplo (aunque probablemente el más destacado) de ello. Las cámaras que ayudan a detectar, rastrear y reaccionar ante objetos y situaciones alrededor de un vehículo son uno de los componentes clave de la tecnología que permitirá la plena autonomía. Sin embargo, la detección visual tiene los mismos problemas que los ojos: sólo perciben lo que ven y se ven afectados por las inclemencias del tiempo, la mala iluminación y otros factores ambientales. En tales circunstancias, la potencia de cálculo disponible en un solo dispositivo o vehículo deja de ser relevante para el problema en cuestión. En su lugar, debemos ampliar la escala del problema, que es donde se encuentran las posibles soluciones. Los vehículos conectados que recopilan automáticamente datos sobre el entorno y el comportamiento al volante pueden convertirse rápidamente en un vasto canal de agregación de información colectiva. Junto con otras modalidades de detección (radar, Lidar), el uso de información cartográfica obtenida por crowdsourcing se considera ahora el tercer pilar sobre el que descansa la consecución de la plena autonomía. Lo que comenzó como una misión para permitir una integración y entrega más rápidas de soluciones de seguridad con ADAS a las flotas, se ha convertido ahora en un vibrante ecosistema de algunos de los mayores y más innovadores proveedores de servicios telemáticos (TSP) que impulsan soluciones de seguridad para el conductor a través de RideView. Miles de conductores de vehículos comerciales y gestores de flotas de todo el territorio continental de Estados Unidos y Canadá confían en las alertas en tiempo real y en la información práctica para garantizar la seguridad de sus flotas las 24 horas del día. ¿Un subproducto inmensamente beneficioso? Una red de miles de cámaras conectadas que recopilan una gran cantidad de datos anónimos sobre señales de tráfico, calidad de las carreteras, patrones de comportamiento al volante y mucho más.

Crowdsourced Event Generator, una mejora de nuestro motor de generación de eventos en tiempo real basado en ADAS. El primer caso de uso es el más sencillo y, sin embargo, su elegancia presagia todo lo que es posible. El reconocimiento y cumplimiento en tiempo real de los límites de velocidad y las señales de STOP ha sido desde el principio una de las principales propuestas de valor de nuestra plataforma. Se sabe que el exceso de velocidad es uno de los principales indicadores de riesgo de accidente, y nuestras alertas al conductor en tiempo real ayudan a mitigarlo. Además, al no depender de las bases de datos de límites de velocidad existentes que se actualizan con poca frecuencia, se garantiza que las flotas estén siempre al día de los límites que ven en la operación diaria. Sin embargo, como ya se ha mencionado, hay puntos ciegos literales en esa dependencia exclusiva de la cognición visual. En condiciones meteorológicas adversas (niebla, lluvia, nieve, etc.), con mala iluminación o incluso cuando un obstáculo temporal tapa una señal (por ejemplo, un camión de clase 8 en el carril más a la derecha), el sistema llega a sus límites. Gracias a los miles de vehículos de nuestra plataforma, ahora tenemos una cobertura significativa y orgánica de las señales de tráfico en toda Norteamérica, como se muestra en la figura anterior. Cada vez que un vehículo de nuestra plataforma detecta un nuevo límite de velocidad o una señal de STOP, se etiqueta con su ubicación y se añade a un corpus cada vez mayor. Un algoritmo de filtrado y consenso en el backend genera una base de datos depurada, de la que sólo una pequeña parte se descarga y se aplica en función de la ubicación actual. Libres de las limitaciones de lo que percibe un único sistema basado en la visión, nuestros algoritmos pueden ahora "ver" en la oscuridad, bajo la lluvia e incluso cuando las señales están completamente ocultas por los vehículos que pasan. La abrumadora respuesta de los primeros usuarios ha sido muy positiva, y estamos deseando ayudar a nuestros socios a ponerlo a disposición de los usuarios finales en los próximos meses. Dicho esto, aunque consideramos que se trata de un hito importante, aún no es el primer día. En las próximas semanas y meses iremos introduciendo mejoras que aprovechen todos los datos valiosos que seguimos recopilando a gran escala. Desde la detección y difusión de las señales temporales de límite de velocidad que aparecen en las zonas de trabajo hasta la alerta anticipada a los conductores sobre los puntos conflictivos de accidentes o conducción temeraria, nos centraremos en habilitar los casos de uso que aporten más valor a nuestros socios y usuarios finales.